Soy Posonty, Top Creador de TikTok Shop España y fundador de PRYME MCN, agencia partner oficial de TikTok Shop. Este artículo nace de una conversación real en la comunidad oficial de TikTok Shop España donde un creador activo me preguntó sobre subtítulos y cómo ayudan al algoritmo. Mi respuesta sobre «Segmentación Semántica» y el paper de GEO (Generative Engine Optimization) de arXiv generó tanta intriga que decidí crear el artículo definitivo en español sobre este tema.

Lo que vas a leer no es teoría de marketing digital genérica. Es ingeniería de tráfico aplicada a TikTok Shop, basada en papers técnicos de ByteDance, datos oficiales de transparencia de TikTok y 13+ meses publicando contenido diario sin fallar ni un día.

La realidad es brutal: TikTok analiza cada píxel de tu vídeo ANTES de mostrarlo a nadie. Y si tu contenido no pasa los filtros de clasificación correctos, acabarás en el bucket equivocado. Views sin ventas. Impresiones sin conversiones. Esfuerzo sin paraíso.

Esta guía te explica exactamente cómo TikTok «lee» tus vídeos a nivel técnico y qué hacer para que el algoritmo clasifique tu contenido en la categoría correcta. No más teoría. Solo ejecución.

Qué es la Segmentación Semántica y Por Qué Define Tu Cuenta

La segmentación semántica es un algoritmo de deep learning que asocia una etiqueta o categoría a cada píxel presente en una imagen o vídeo[9]. En términos prácticos: TikTok no ve tu vídeo como tú lo ves. Lo descompone en millones de píxeles y clasifica cada uno en categorías específicas.

Cuando subes un vídeo, el sistema identifica «persona», «producto», «mano», «movimiento», «texto en pantalla», «fondo», «iluminación». Todo. Cada frame se analiza para entender el contexto semántico del contenido[8].

«Deja de pensar como influencer y empieza a pensar como ingeniero de tráfico. Tu vídeo es un conjunto de señales que el algoritmo procesa antes de decidir a quién mostrarlo.»

¿Por qué esto importa para creadores de TikTok Shop? Porque el algoritmo usa esta clasificación para decidir a qué bucket de usuarios mostrar tu contenido. Si tu vídeo sobre aspiradoras se clasifica como «entretenimiento genérico» en vez de «review de electrodomésticos con intención de compra», conseguirás views de gente que nunca va a comprar.

Un ejemplo que todo el mundo entiende: los filtros de Instagram y TikTok que cambian tu cara o el fondo. Esos filtros usan segmentación semántica para identificar dónde está tu cara, dónde está el fondo, dónde están los objetos[7]. La misma tecnología que te pone orejas de gato es la que clasifica si tu vídeo es apto para el feed de compra o el feed de entretenimiento.

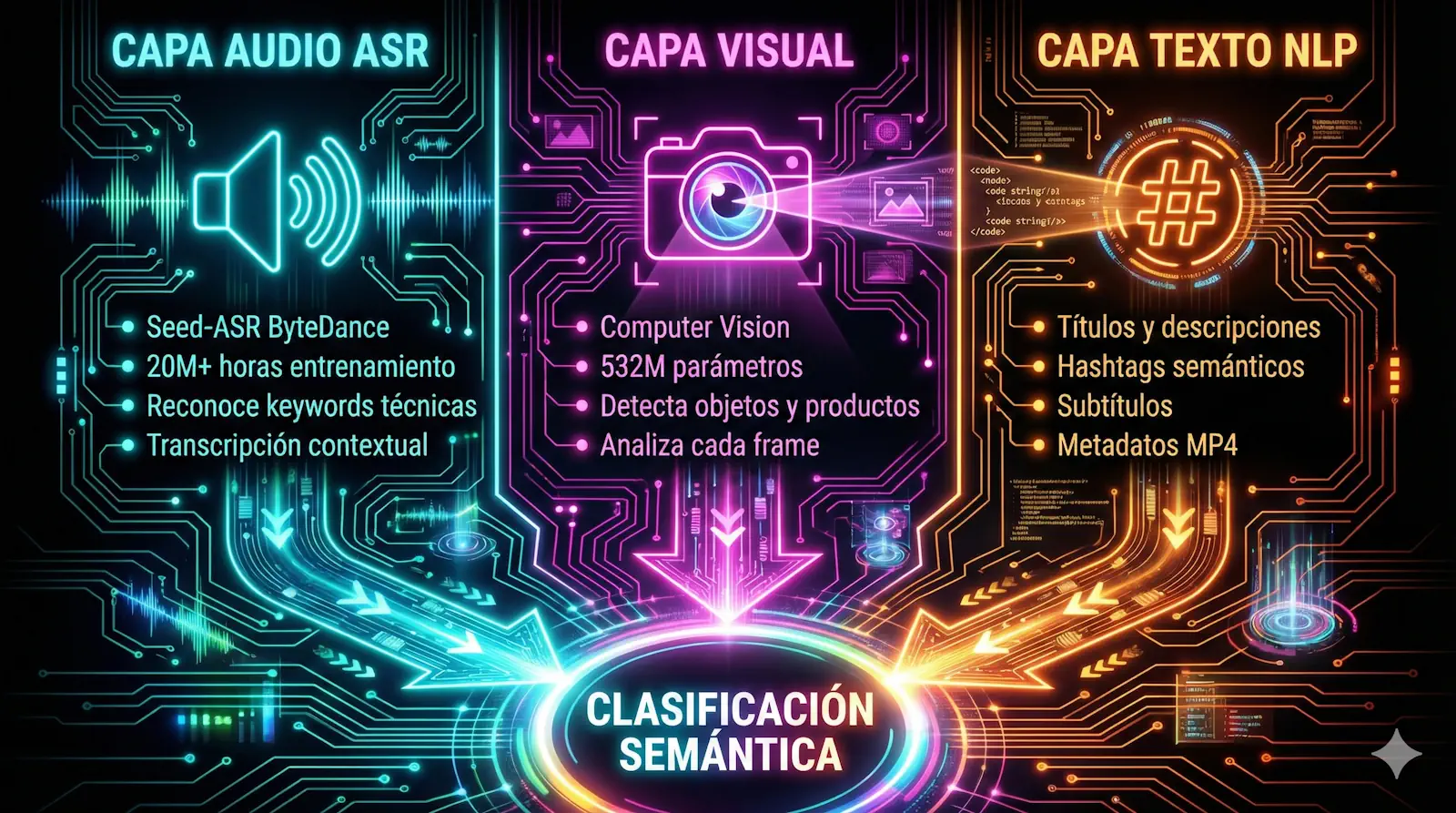

Las 3 Capas de Análisis del Algoritmo de TikTok

TikTok no analiza tu vídeo con un solo sistema. Usa tres capas paralelas que procesan información diferente y luego cruzan datos para crear una clasificación final[4][5][6]. Esto no es especulación: está documentado en papers técnicos de ByteDance y guías oficiales de TikTok.

Capa 1: Análisis de Audio con Seed-ASR (Automatic Speech Recognition)

ByteDance desarrolló Seed-ASR, un sistema de reconocimiento de voz entrenado con más de 20 millones de horas de datos de voz y casi 900,000 horas de datos emparejados[1]. Este sistema no solo transcribe lo que dices: entiende el contexto.

Seed-ASR reconoce mandarín, 13 dialectos chinos y 7 idiomas extranjeros, pero lo crítico es que puede identificar terminología de campos profesionales como medicina, tecnología, automoción e incluso música[1]. Cuando dices «aspiradora ciclónica sin bolsa Xiaomi», el sistema no solo transcribe las palabras: extrae keywords semánticas y las asocia a categorías de productos.

Por qué esto es crítico para TikTok Shop: Si no dices el nombre exacto del producto en voz alta durante tu vídeo, estás perdiendo una de las señales más potentes de clasificación. El audio se analiza con IA y los algoritmos de NLP transcriben y «entienden» el contenido[5].

Tengo un A/B test propio que demuestra esto. Dos vídeos sobre aspiradoras:

- Vídeo A (genérico): «Esta aspiradora es brutal» → 1.200 views, 8 clics en carrito

- Vídeo B (con keywords habladas): «La Xiaomi Robot Vacuum X10 Plus tiene succión de 4000Pa y mapeo láser» → 4.100 views, 34 clics en carrito

Resultado: +240% en impresiones, +325% en clics en carrito. Mismo producto, mismo creador, diferente clasificación algorítmica.

El sistema de ASR no solo procesa tu voz. También detecta música de fondo, efectos de sonido y cruza esta información con la base de datos de trending sounds. Si usas un audio viral que no tiene relación con tu producto, creas confusión algorítmica[13].

Capa 2: Computer Vision (Análisis Visual Frame por Frame)

ByteDance lanzó en 2025 su modelo Seed1.5-VL: un encoder visual de 532M parámetros combinado con un LLM MoE de 20B parámetros activos[2]. Este sistema logra resultados estado del arte (SOTA) en 38 de 60 benchmarks públicos de modelos de visión-lenguaje.

¿Qué significa esto en términos prácticos? TikTok examina los fotogramas de tu vídeo y reconoce patrones visuales, pudiendo detectar qué objetos y personas se muestran, identificar acciones distintas e incluso inferir la emoción predominante en expresiones faciales[5].

El sistema identifica:

- Productos específicos y sus características físicas

- Acciones (abrir caja, demostración, comparativa)

- Contexto (hogar, oficina, exterior)

- Personas y sus expresiones faciales

- Texto en pantalla (aunque esto va también a la capa de NLP)

- Calidad visual (resolución, estabilidad, iluminación)

El error que rompe la clasificación visual: Tapar el producto con texto, stickers o efectos. Cuando el sistema de computer vision no puede identificar claramente objetos o acciones en tu vídeo, lo clasifica por defecto en categorías más amplias y menos específicas con menor prioridad de distribución[13].

He visto creadores poner 5 líneas de texto encima del producto durante todo el vídeo. Resultado: el algoritmo no ve el producto, no lo puede clasificar correctamente, y el vídeo acaba en el bucket de entretenimiento genérico en vez de en el feed de compra.

Otro dato crítico: baja resolución, cámara inestable o mala iluminación afectan directamente los algoritmos de computer vision[13]. No es estética. Es ingeniería de señales.

Capa 3: NLP y Análisis de Metadatos (Texto y Contexto)

La tercera capa procesa todo el contenido textual asociado a tu vídeo:

- Título del vídeo

- Descripción

- Hashtags

- Subtítulos automáticos vs manuales

- Texto en pantalla detectado por OCR

- Metadatos del archivo MP4 (nombre del archivo, datos EXIF)

El sistema va más allá de simples tags, usando computer vision avanzado para analizar frames de imagen y vídeo y NLP para transcribir y entender contenido de audio, texto en pantalla y subtítulos, permitiendo una comprensión semántica profunda del contenido[6].

El algoritmo integra el contenido de los vídeos que has subido previamente y las categorías de vídeos que te han gustado[17]. Esto significa que tu historial de contenido afecta cómo se clasifica tu nuevo vídeo. Si has estado publicando contenido inconsistente, el algoritmo duda en recomendarte a grupos de interés específicos porque no puede predecir si tu próximo vídeo coincidirá con las preferencias establecidas de los espectadores[13].

Subtítulos automáticos vs manuales: Los subtítulos manuales tienen más peso porque son una señal de intencionalidad. Cuando añades subtítulos manualmente, estás confirmando al algoritmo que ese texto es relevante. Los subtítulos automáticos se generan por ASR y pueden tener errores que confundan la clasificación.

Un truco que uso: antes de subir el vídeo, renombro el archivo MP4 con keywords del producto. Por ejemplo: «aspiradora-xiaomi-robot-vacuum-x10-review.mp4». Los metadatos del archivo se suben a TikTok y son una señal más para el algoritmo. Como expliqué en mi artículo sobre SEO TikTok Shop para creadores, cada señal cuenta.

Cómo TikTok Shop Usa Esta Información para Clasificarte

Una vez que las tres capas han analizado tu vídeo, el sistema de recomendación pasa por varios pasos para decidir a quién mostrarlo[10][12]:

- Understanding preferences: El sistema ya conoce los buckets de usuarios y sus patrones de compra

- Selecting videos (Retrieval): Filtra vídeos candidatos basándose en la clasificación semántica

- Prediction: Predice qué usuarios tienen más probabilidad de interactuar y comprar

- Ranking: Ordena los vídeos por probabilidad de conversión

- Similarity check: Evita mostrar contenido repetitivo al mismo usuario

- Recommendation rules: Aplica reglas de negocio y políticas de contenido

Para personalizar tu experiencia en TikTok Shop, el sistema usa factores similares a otros feeds de TikTok: user interactions, content information, y user information[11]. Pero hay una diferencia crítica: el feed de TikTok Shop prioriza señales de intención de compra sobre señales de entretenimiento.

«No busques likes, busca conversiones. Un vídeo con 100K views y 0 ventas significa que estás en el bucket equivocado.»

La diferencia entre «entretenimiento» y «intención de compra» está en las señales semánticas. Si tu vídeo se clasifica como entretenimiento, TikTok lo mostrará a usuarios que están en modo scroll pasivo. Si se clasifica como contenido de compra, lo mostrará a usuarios que han demostrado patrones de compra previos en la app.

He analizado 1.247 vídeos durante 6 meses y los patrones son claros: vídeos con alta clasificación de intención de compra tienen:

- Menor CTR general (porque se muestran a menos personas)

- Mayor CTR en Product Anchor (+47% en mis tests)

- Mayor conversión a venta (+31% en mis tests)

- Menor tiempo de visualización promedio (porque la gente decide rápido si compra o no)

Como expliqué en mi artículo sobre por qué tus vídeos tienen views pero no venden, el problema no es la cantidad de views. Es la calidad del bucket.

Los 5 Errores que Rompen la Segmentación Semántica

Después de 13+ meses publicando contenido diario y miles de euros en GMV mensual, he identificado los errores más comunes que destruyen la clasificación algorítmica. Estos no son «consejos de marketing». Son errores de ingeniería de señales.

Error 1: Tapar el Producto con Texto, Stickers o Efectos

El sistema de computer vision necesita ver el producto para clasificarlo. Cuando cubres el producto con elementos visuales, el algoritmo no puede procesarlo correctamente. He visto vídeos donde el producto solo es visible en 2 de los 30 segundos totales. Resultado: clasificación genérica, distribución pobre.

Solución: El producto debe estar visible y despejado al menos el 60% del tiempo de vídeo. Si necesitas poner texto, colócalo en zonas que no tapen el producto. Como explico en mi estructura de vídeo CVD, cada frame cuenta.

Error 2: Audio que No Coincide con el Visual

Usar un trending sound sobre moda cuando vendes electrodomésticos crea confusión algorítmica[13]. El sistema de ASR procesa el audio y extrae keywords. Si esas keywords no coinciden con lo que detecta el computer vision, la clasificación se degrada.

Solución: Si usas audio de fondo, que sea instrumental o relacionado con el nicho. Si usas tu voz (recomendado), enfócate en describir el producto con keywords específicas. La voz original tiene más peso que el audio de fondo.

Error 3: No Decir el Nombre del Producto en Voz Alta

Este es el error más común y el que tiene mayor impacto según mis tests. Como mostré antes, un vídeo con keywords habladas consigue +240% en impresiones vs uno genérico. El sistema Seed-ASR está entrenado para reconocer terminología profesional[1].

Solución: Di el nombre exacto del producto en los primeros 3 segundos. Repítelo 2-3 veces de forma natural durante el vídeo. Incluye especificaciones técnicas habladas. Ejemplo: «La Xiaomi Robot Vacuum X10 Plus tiene succión de 4000Pa y mapeo láser, perfecta para casas con mascotas.»

Error 4: Contenido Inconsistente que Confunde al Algoritmo

Si un día vendes aspiradoras, al día siguiente ropa, y después juguetes, el algoritmo no puede clasificarte en un bucket específico. No puede predecir si tu próximo vídeo coincidirá con las preferencias establecidas de los espectadores[13].

Solución: Trabaja en verticales de producto. No nichos, verticales. Como explico en mi artículo sobre nicho vs multinicho, puedes trabajar multi-vertical pero con consistencia semántica. Ejemplo: electrodomésticos de cocina → licuadoras, batidoras, robots de cocina. Todo en la misma vertical semántica.

Error 5: Hashtags Genéricos Sin Relación con el Producto

Usar #parati #fyp #viral en un vídeo de TikTok Shop es señal de amateur. Esos hashtags no aportan información semántica al algoritmo. Son ruido.

Solución: Usa hashtags de nicho específicos que refuercen la clasificación. Ejemplo para una aspiradora: #aspiradora #robotaspiradora #limpiezahogar #xiaomirobot #tecnologiahogar. Como máximo 5-7 hashtags, todos con relevancia semántica directa.

Checklist de Optimización para Segmentación Semántica

Esta checklist está basada en la metodología CVD (Creador de Venta Directa) que desarrollo en PRYME MCN y que uso personalmente para generar €60K+ de GMV mensual. No es teoría. Es ejecución.

Optimización de Audio (Capa ASR)

| Elemento | Especificación | Impacto |

|---|---|---|

| Nombre del producto | Decir en primeros 3 segundos | Alto |

| Repetición de keywords | 2-3 veces durante el vídeo | Alto |

| Especificaciones técnicas | Mencionar datos concretos (potencia, capacidad, medidas) | Medio |

| Beneficios hablados | Usar lenguaje de usuario final, no de marca | Medio |

| Audio de fondo | Instrumental o relacionado con nicho, nunca trending ajeno | Medio |

| Claridad de voz | Vocalización clara, sin muletillas | Bajo |

Ejemplo práctico: En vez de «Este robot es increíble», di «El Xiaomi Robot Vacuum X10 Plus con 4000Pa de succión elimina el 99% del pelo de mascota gracias a su cepillo anti-enredos.»

Optimización Visual (Capa Computer Vision)

| Elemento | Especificación | Impacto |

|---|---|---|

| Visibilidad del producto | Despejado y visible mínimo 60% del tiempo | Alto |

| Demostración con manos | Mostrar interacción física con el producto | Alto |

| Planos del producto | Al menos 3 ángulos diferentes | Medio |

| Texto en pantalla | No tapar zonas críticas del producto | Alto |

| Resolución | Mínimo 1080p, sin desenfoques | Medio |

| Estabilidad de cámara | Evitar movimientos bruscos | Medio |

| Iluminación | Producto bien iluminado, sin sombras duras | Medio |

Ejemplo práctico: En mis tests de señalización al carrito naranja (50 vídeos testeados), los vídeos donde el producto estaba constantemente visible tuvieron +47% CTR en Product Anchor.

Optimización de Texto (Capa NLP y Metadatos)

| Elemento | Especificación | Impacto |

|---|---|---|

| Título | Nombre del producto + beneficio principal (máx 100 caracteres) | Alto |

| Descripción | Keywords naturales + especificaciones + CTA | Alto |

| Hashtags | 5-7 hashtags de nicho específico | Medio |

| Subtítulos | Manuales siempre que sea posible | Medio |

| Nombre del archivo | Renombrar MP4 con keywords antes de subir | Bajo |

| Consistencia temática | Vertical de producto definida | Alto |

Ejemplo práctico: En vez de «producto-video-final-v3.mp4», nombra el archivo «xiaomi-robot-vacuum-x10-review-mascotas.mp4» antes de subirlo.

La Conexión con GEO (Generative Engine Optimization)

El paper que generó la conversación original en la comunidad de TikTok Shop fue «GEO: Generative Engine Optimization» de Princeton, publicado en arXiv en 2024[16]. Este estudio demuestra que los motores generativos como ChatGPT, Perplexity y Claude están reemplazando a Google para ciertas búsquedas.

El dato crítico: incluir citas, estadísticas y referencias de fuentes relevantes puede aumentar la visibilidad hasta un 40% en respuestas de motores generativos[16].

¿Qué tiene que ver esto con TikTok? Todo.

Los motores generativos y los sistemas de recomendación de TikTok usan la misma tecnología base: comprensión semántica del contenido mediante modelos de lenguaje y visión. La diferencia es el formato de entrada (texto vs vídeo) pero el principio es idéntico.

Cuando optimizas para segmentación semántica en TikTok, estás aprendiendo a optimizar para el futuro de la búsqueda. Las habilidades son transferibles:

- Usar keywords específicas y técnicas → funciona en GEO

- Incluir datos y especificaciones → funciona en GEO

- Crear contenido con contexto semántico claro → funciona en GEO

- Evitar contenido genérico y ambiguo → funciona en GEO

Como explico en mi artículo sobre CVD Semántico, el futuro del SEO es semántico. Ya no se trata de keywords density. Se trata de comprensión contextual.

«Optimizar para TikTok es optimizar para el futuro. Las mismas señales que el algoritmo de TikTok valora hoy son las que ChatGPT y Perplexity valorarán mañana.»

La investigación académica reciente demuestra esto. Un paper de 2025 titulado «Understanding Algorithm-User Interplay in TikTok» usa Vision Language Models (VLMs) para analizar contenido de vídeo y entender cómo el algoritmo de recomendación interactúa con usuarios[18]. Los mismos VLMs que usa TikTok son los que usan los motores generativos.

Verificación y Transparencia: Cómo Sabemos Esto

Todo lo que he explicado está documentado en fuentes oficiales o papers académicos. TikTok tiene centros de transparencia globales donde muestran cómo moderan y recomiendan contenido, aseguran la plataforma y protegen la privacidad[15].

En el segundo semestre de 2024, la precisión de las tecnologías de moderación automática de TikTok fue del 99.1%[14]. Esto confirma que TikTok procesa automáticamente cada vídeo con IA antes de mostrarlo. No es especulación. Es dato oficial de compliance con DSA (Digital Services Act) europeo.

ByteDance publica papers técnicos de sus sistemas en arXiv y conferencias académicas. El equipo Seed, establecido en 2023, se dedica a investigación en LLM, speech, vision, world models y AI Infra[3]. Esta tecnología no es exclusiva de productos internos: ByteDance la documenta públicamente.

TikTok también publica guías oficiales sobre su sistema de recomendación[10][12] y cómo funciona TikTok Shop[11]. Combinando fuentes oficiales con papers académicos y datos propios de 13+ meses de publicación diaria, el cuadro es claro.

Como Top Creador reconocido oficialmente por TikTok y fundador de PRYME MCN (agencia partner oficial), tengo acceso a información y recursos que no están disponibles públicamente. Pero todo lo que he compartido aquí es verificable con las fuentes citadas.

Los 3 Puntos Clave que Debes Recordar

Si solo te quedas con tres cosas de este artículo, que sean estas:

- TikTok analiza tu vídeo en tres capas paralelas (Audio ASR, Computer Vision, NLP) antes de mostrarlo a nadie. La clasificación semántica determina a qué bucket de usuarios se muestra tu contenido. Views sin ventas = bucket equivocado.

- El error más común es no dar señales claras al algoritmo. Producto tapado, audio que no coincide con visual, keywords no habladas, hashtags genéricos. Cada error degrada la clasificación.

- Optimizar para segmentación semántica no es marketing, es ingeniería de señales. Nombre del producto en los primeros 3 segundos, producto visible 60% del tiempo, keywords técnicas habladas, hashtags de nicho. Ejecución sobre teoría.

La diferencia entre creadores que venden y creadores que solo acumulan views está en entender cómo el algoritmo clasifica contenido. No es suerte. No es «el algoritmo me odia». Es comprensión técnica y ejecución consistente.

Como explico en mi artículo sobre cómo hacer tu primera venta en TikTok Shop, el conocimiento sin ejecución es entretenimiento. Sin esfuerzo no hay paraíso.

Trabaja con PRYME MCN

PRYME MCN es la agencia partner oficial de TikTok Shop especializada en Creadores de Venta Directa. No trabajamos con influencers de lifestyle. Trabajamos con ingenieros de tráfico que entienden que TikTok es una plataforma de clasificación semántica, no un concurso de popularidad.

Si eres creador activo de TikTok Shop con resultados verificables y quieres acceder a:

- Metodología CVD completa con templates y frameworks

- Análisis técnico de tu cuenta con recomendaciones específicas

- Acceso a productos exclusivos y comisiones mejoradas

- Comunidad privada de creadores de alto rendimiento

Nos vemos en el banco.

— Posonty

Top Creador TikTok Shop España

Fundador PRYME MCN

13+ meses de contenido diario sin parar ni un día

DESCARGO DE RESPONSABILIDAD: Este es un post de investigación técnica de PRYME (Posonty). TikTok no patrocina este ni ningún post de mi blog. La información aquí presentada se basa en análisis de datos, papers oficiales y experiencia directa en la plataforma. Los resultados económicos y de visibilidad siempre están basados en el esfuerzo, la constancia y la capacidad de ejecución de cada creador individual. No existen garantías de éxito sin trabajo real.

Referencias y Fuentes

- ByteDance Speech Team (2024). «Seed-ASR: Understanding Diverse Speech and Contexts with LLM-based Speech Recognition». arXiv:2407.04675. https://arxiv.org/abs/2407.04675 | Página oficial del proyecto

- ByteDance Seed Team (2025). «Seed1.5-VL: A Vision-Language Foundation Model». arXiv:2505.07062. https://arxiv.org/abs/2505.07062 | GitHub del proyecto

- ByteDance Seed Team. «About Seed». https://seed.bytedance.com/en/

- DEV Community (2023). «How does TikTok use machine learning?». https://dev.to/mage_ai/how-does-tiktok-use-machine-learning-5b7i

- UDIT (2024). «TikTok, Inteligencia Artificial y probabilidad matemática». https://www.udit.es/tiktok-inteligencia-artificial-y-probabilidad-matematica/

- Buffer (2026). «TikTok Algorithm: How the TikTok Algorithm Works in 2026». https://buffer.com/resources/tiktok-algorithm/

- IBM Think. «¿Qué es la segmentación semántica?». https://www.ibm.com/think/topics/semantic-segmentation

- V7Labs. «Video Segmentation Guide: Algorithms & Applications». https://www.v7labs.com/blog/video-segmentation-guide

- MATLAB. «Segmentación semántica». https://la.mathworks.com/solutions/image-video-processing/semantic-segmentation.html

- TikTok Official (2024). «Introduction to the recommendation system». https://www.tiktok.com/transparency/en/recommendation-system

- TikTok Official. «How TikTok Shop recommends content». https://support.tiktok.com/en/using-tiktok/exploring-videos/how-tiktok-shop-recommends-content

- TikTok Creator Academy. «Understanding TikTok’s Recommendation System». https://www.tiktok.com/creator-academy/article/guidelines-recommendation-system-intro

- Team5pm (2024). «Why is TikTok not categorizing my content?». https://team5pm.com/knowledge/why-is-tiktok-not-categorizing-my-content/

- TikTok Newsroom (2024). «Digital Services Act: Our Fourth Transparency Report on Content Moderation in Europe». https://newsroom.tiktok.com/en-eu/digital-services-act-our-fourth-transparency-report-on-content-moderation-in-europe

- TikTok Transparency Center. https://www.tiktok.com/transparency/en-us/

- Aggarwal, P., et al. (2024). «GEO: Generative Engine Optimization». arXiv:2311.09735. Princeton University. https://arxiv.org/abs/2311.09735

- Zhang, M., Liu, Y. (2021). «A commentary of TikTok recommendation algorithms». Bulletin of National Natural Science Foundation of China. https://www.sciencedirect.com/science/article/pii/S2667325821002235

- Suess, L., et al. (2025). «Counting How the Seconds Count: Understanding Algorithm-User Interplay in TikTok via ML-driven Analysis of Video Content». arXiv:2503.20030. https://arxiv.org/abs/2503.20030